🍺 AIはバーに現れる

ある日、こんな話を聞きました。

「うち、AI作りました」

お、最近よく聞くやつだ。

スライドもきれい、グラフもそれっぽい。

🧪 テスト環境(発表用)

客がバーに入る

ビールを頼む → 客

0杯 → 客じゃない

999999999杯 → 上客

トカゲ → 客じゃない

-1杯 → 客じゃない

ueicbksjdhd → 客じゃない会場、うなずく。

「おお…AIですね」

🚨 本番環境(現実)

客:「すみません、トイレどこですか?」💥 ブルースクリーン

💥 サービス停止

💥 Slackが鳴り止まない

🧠 それ、AIじゃない

それは

「想定内の世界でだけ生きられるプログラム」です。

現実はいつも

「想定外」から殴ってきます。

🤔 そもそもAIって何?

AIという言葉、

SFとマーケティングでだいぶ盛られています。

でも、エンジニア的に言うと、AIはこうです。

「人間がやってる“それっぽい判断”を、数学で近似する仕組み」

夢も意思もありません。

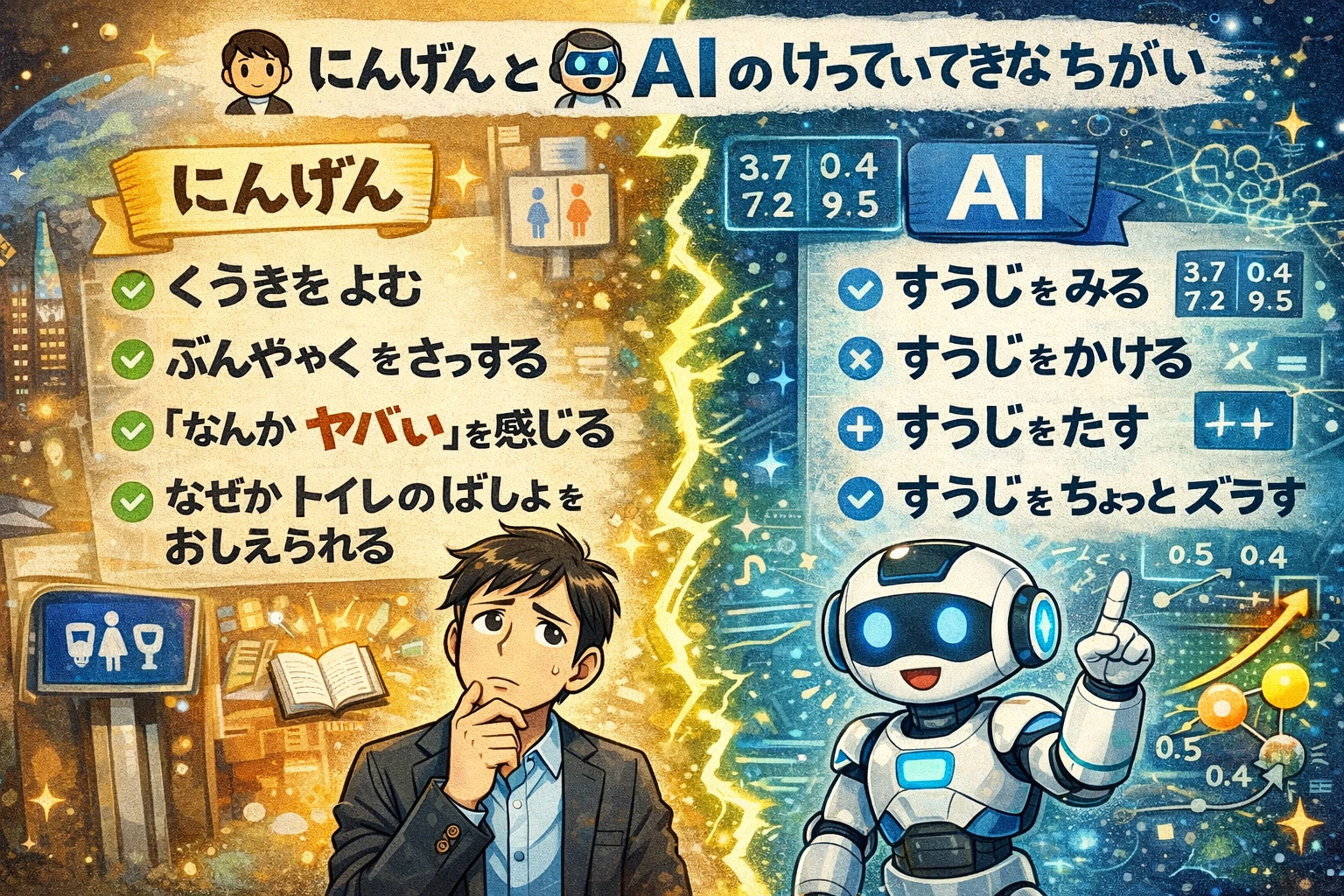

🧍 人間と 🤖 AI の決定的な違い

人間

- 空気を読む

- 文脈を察する

- 「なんかヤバい」を感じる

- なぜかトイレの場所を教えられる

AI

- 数字を見る

- 数字を掛ける

- 数字を足す

- 数字をちょっとズラす

以上。

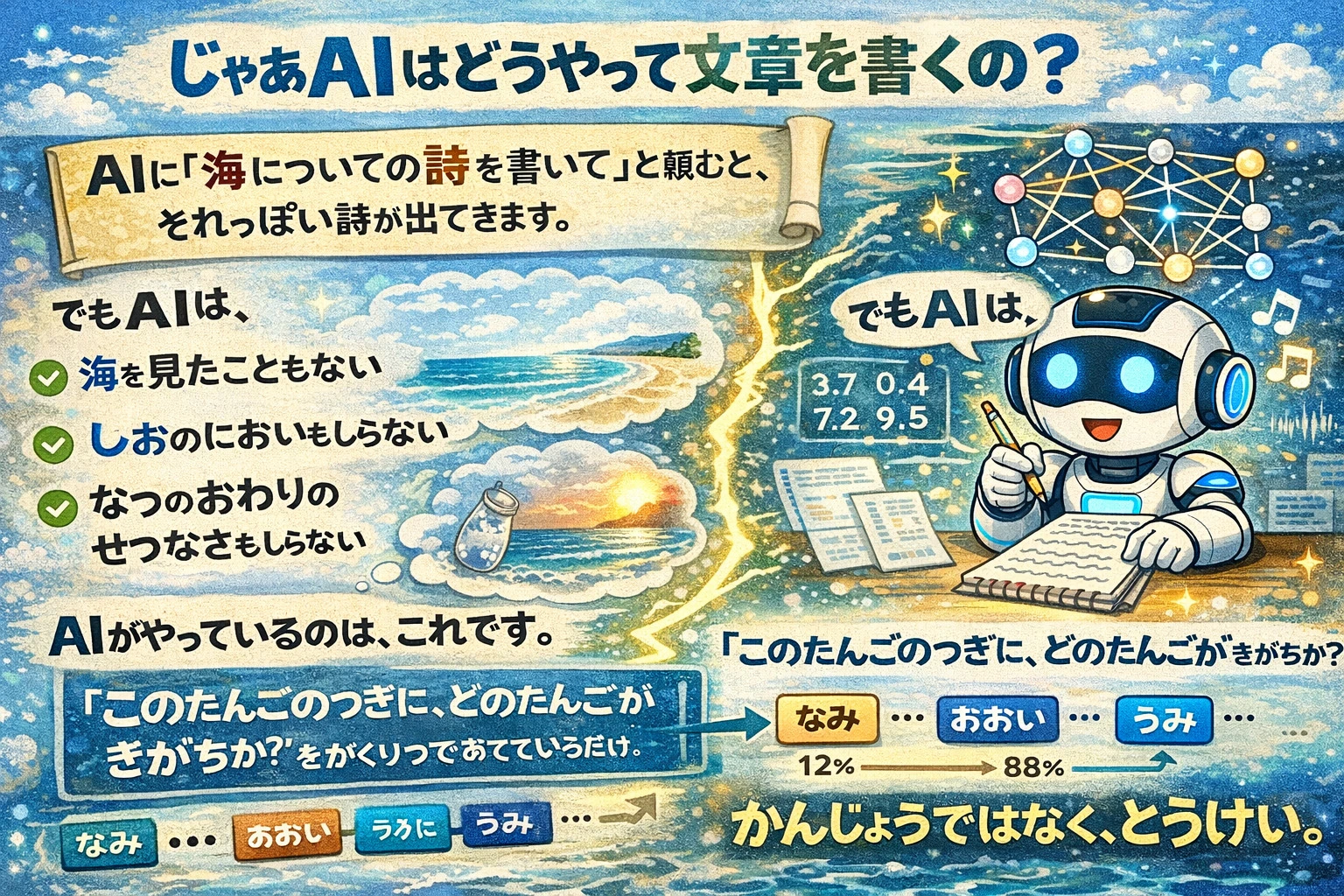

✍️ じゃあAIはどうやって文章を書くの?

AIに「海についての詩を書いて」と頼むと、

それっぽい詩が出てきます。

でもAIは、

- 海を見たこともない

- 潮の匂いも知らない

- 夏の終わりの切なさも知らない

AIがやっているのは、これです。

を確率で当てているだけ。

感情ではなく、統計。

🔁 「結局 if 文の山じゃないの?」

これ、ベテランほど思います。

しかも半分正しい。

🕰 昔のAI

IF A かつ B かつ NOT C

THEN Xこれを増やす。

ひたすら増やす。

結果どうなるか?

- 仕様書が電話帳になる

- 誰も全体を把握できない

- 本番で謎の分岐に落ちる

人類はこれに疲れました。

🧠 現代AIの正体:if 文じゃない

今のAIはこう考えません。

❌「どのルールに当てはまる?」

⭕「この入力、空間のどこにある?」

判断は幾何学です。

🎚 スイッチじゃない、つまみだ

AIの基本ユニットはこんな式です。

y=σ(∑xiwi+b)これ、

ON / OFF じゃありません。

- ちょっと強め

- まあまあ弱め

- ほぼ無視

全部「加減」。

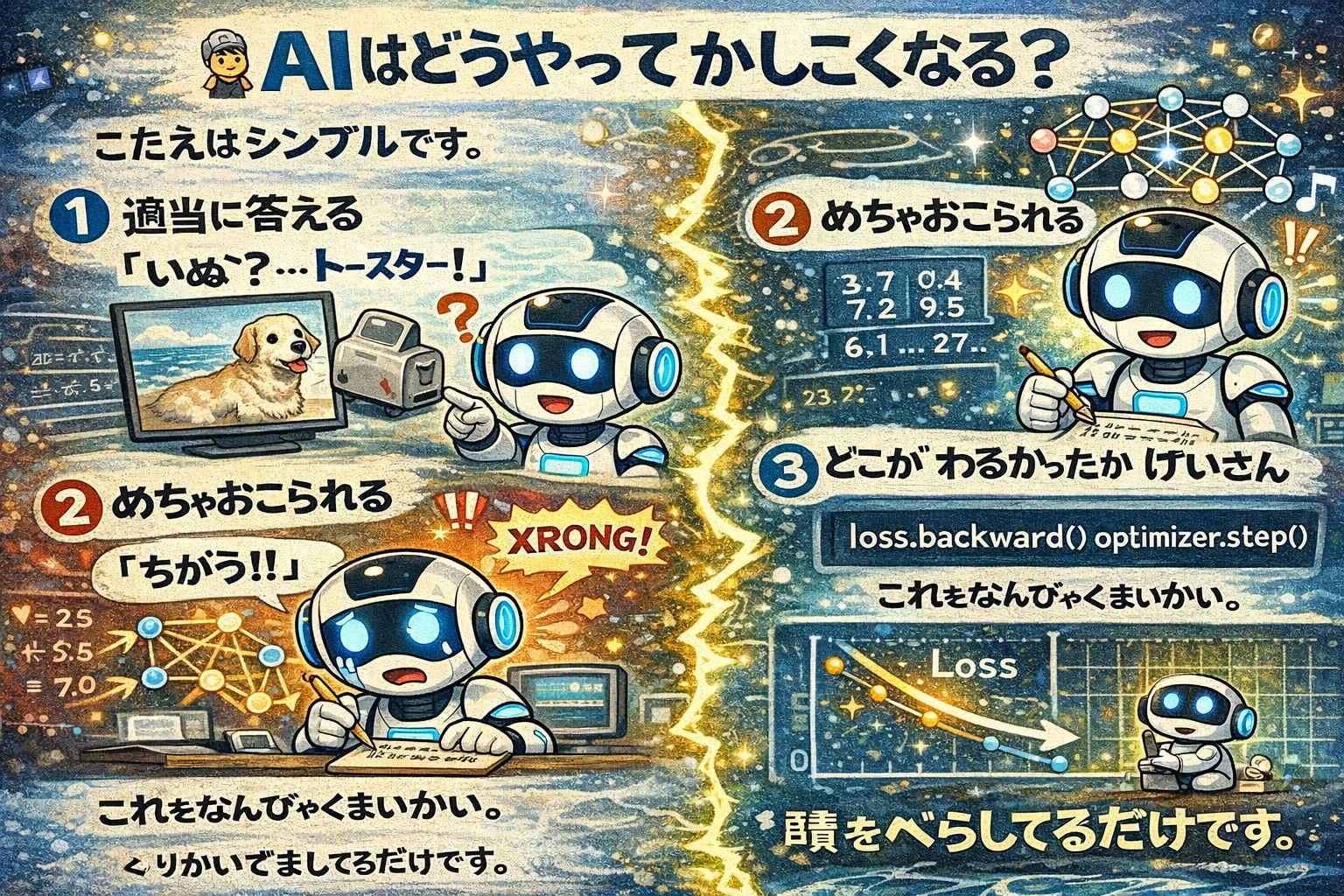

🏋️ AIはどうやって賢くなる?

答えはシンプルです。

1️⃣ 適当に答える

「犬?…トースター!」

2️⃣ めちゃ怒られる

「違う!!」

3️⃣ どこが悪かったか計算

「ここ盛りすぎたな…」

4️⃣ ちょっと直す

loss.backward()

optimizer.step()これを何百万回。

理解?

してません。

誤差を減らしてるだけです。

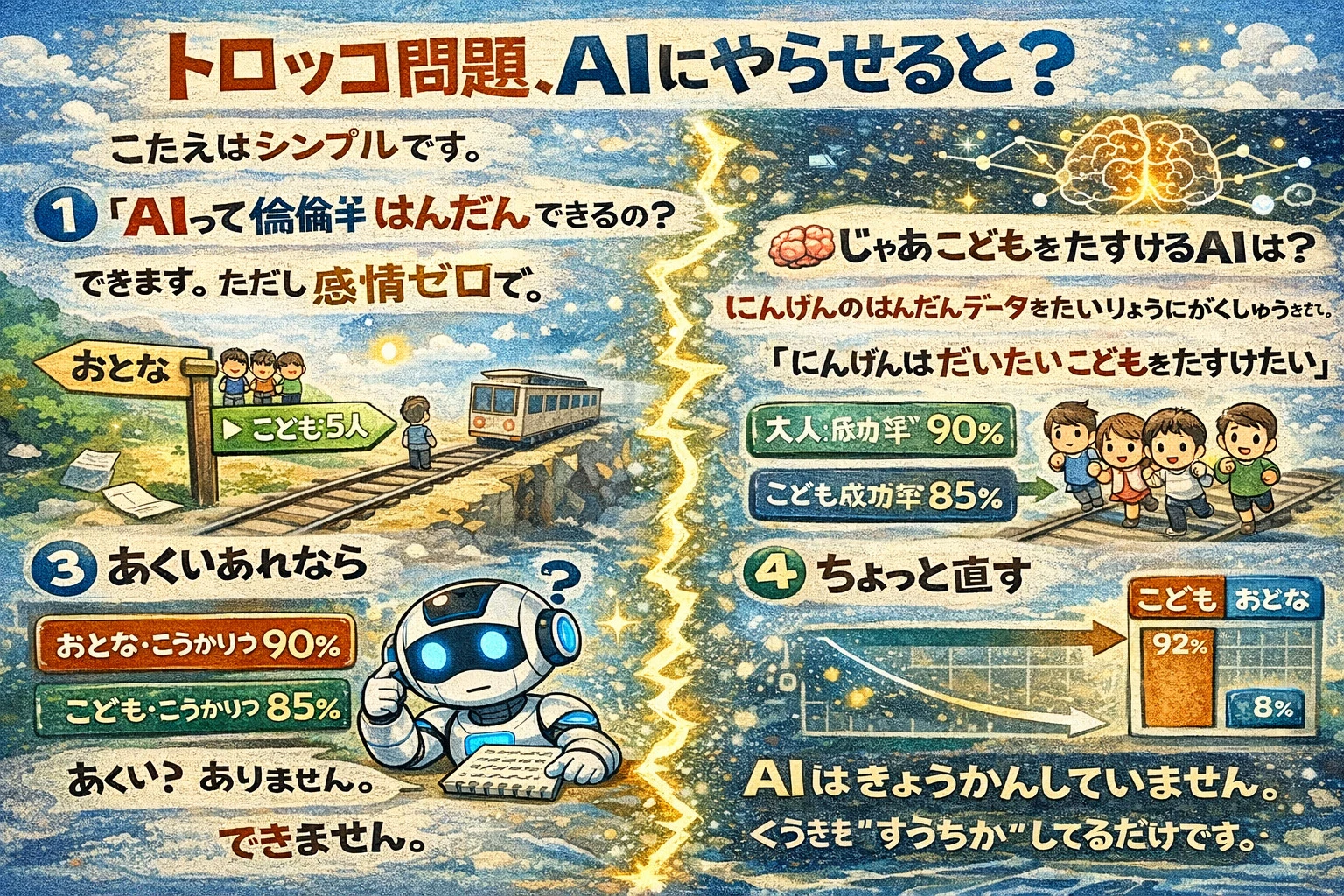

🚋 トロッコ問題、AIにやらせると

「AIって倫理判断できるの?」

できます。

ただし感情ゼロで。

指示がこれなら

「成功確率を最大化せよ」

- 大人:成功率 90%

- 子供:成功率 85%

AIは大人を助けます。

悪意?

ありません。

🧠 じゃあ子供を助けるAIは?

人間の判断データを大量に学習させると、

「人間はだいたい子供を助けたい」

という統計を学びます。

AIは共感していません。

空気を“数値化”してるだけです。

🚗 自動運転の地獄みたいな瞬間

- 時速100km

- 山道

- 子供5人が飛び出す

- 右は崖

AIの頭の中では、

複数の計算が同時に殴り合っています。

# 人命最小化モデル

loss = deaths

# 乗員保護モデル

loss = passenger_riskどっちを重くするか?

それは設計者が決めています。

🦸 人間 vs AI

人間のドライバーは、とっさの判断でハンドルを切るかもしれない。

その行動は、英雄的だと言える。

AIは英雄にはなれない。

できるのは計算だけだ。

では、本当の問いはこれだ。

もし車に乗る前に設定できるとしたら、あなたはどちらを選ぶだろうか?

功利主義モード

自分が犠牲になってでも、最も多くの命を救う。

プロテクターモード

あらゆる状況で、乗員を最優先で守る。